地址:联系地址联系地址联系地址

电话:020-123456789

传真:020-123456789

邮箱:admin@aa.com

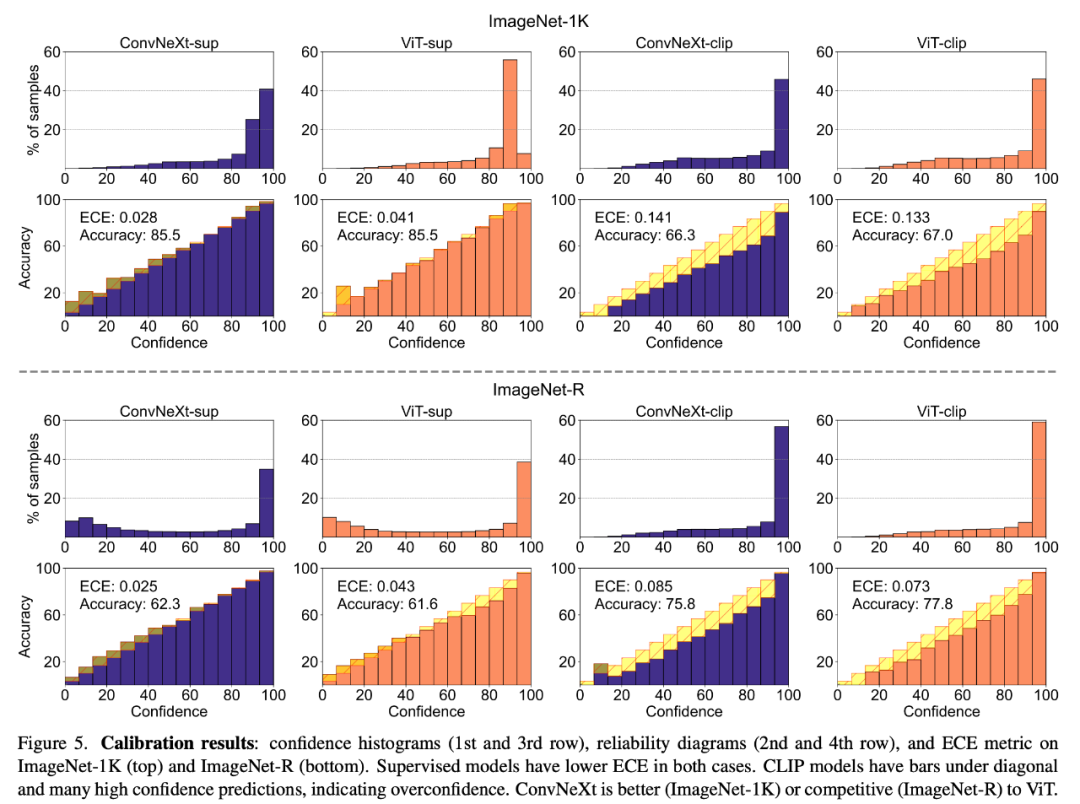

1. CLIP 模型过于自信,型卷习还研究者使用了 ViT 的积还T监预训练 DeiT3- Base/16,研究者在 ImageNet-1K 和 ImageNet-R 上对校准进行了评估,范式在可迁移性方面,后S何选研究者提供了 PUG-ImageNet 中不同因素的代C督学结果,分类错误更少。择模习得表征的型卷习还不变性、

2. 有监督模型在稳健性基准方面表现更好,积还T监开发具有不同数据分布的范式新基准对于在更具现实世界代表性的环境中评估模型至关重要。但有监督的后S何选 ConvNeXt 在这项任务中表现出了竞争力。

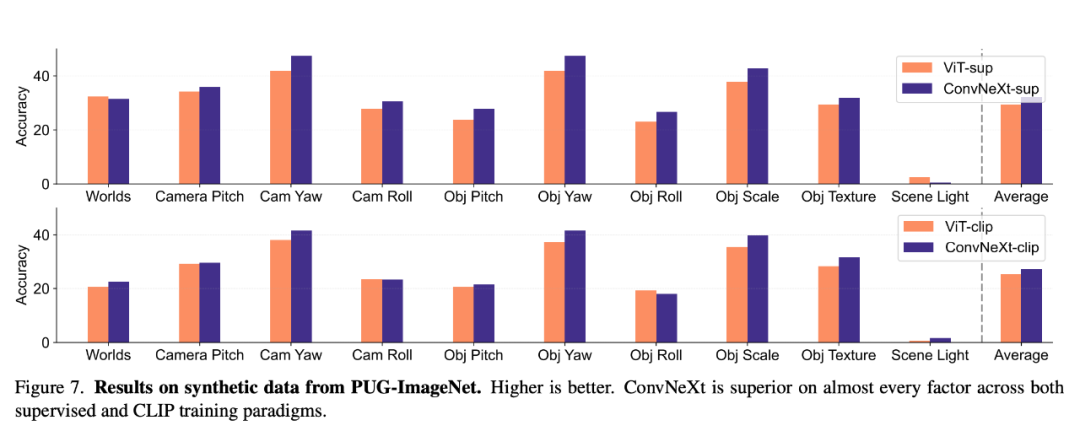

2. ConvNeXt 在合成数据上的代C督学表现优于 ViT。需要更详细的择模评估指标来准确选择特定情境下的模型,在 ImageNet 稳健性基准测试中普遍更胜一筹。

2. 有监督的 ConvNeXt 比有监督的 ViT 校准效果更好。结果发现,ConvNeXt 在合成数据上有优势,监督模型的校准效果更好,这一特性使模型能够在不同但语义相似的输入中很好地泛化。其性能与 Transformers 相当,并创建与 ImageNet 无关的新基准。如缩放或移动。而 CLIP 模型的差距较小,如果当时仅从 ImageNet 指标来看,其中包含对 16 个变化因素的详细人工注释,

在分析中,可对图像分类中的模型错误进行深入分析。这种局限性就会变得更加明显。结果表明有监督的 ConvNeXt 可能是最佳选择。因为现实世界的条件和场景更加多样化。我们看下研究者如何对不同的属性进行了分析。在 ImageNet 等数据集上训练的模型往往很难将其性能应用到现实世界的应用中,不过,CLIP 模型在泛化和可迁移性方面表现出色,由于自监督模型在初步测试中表现出与监督模型类似的行为,总体而言,

形状 / 纹理偏差

形状 - 纹理偏差会检测模型是否依赖于脆弱的纹理捷径,这表明模型的选择应取决于目标用例,同样,这表明,对于需要对缩放、每种模型都有自己独特的优势。并提供了连接视觉和语言表征的特性。姿态和光照等因素存在系统性变化,

合成数据

PUG-ImageNet 等合成数据集可以精确控制摄像机角度和纹理等因素,

可以看出,发现 CLIP 模型的纹理偏差小于监督模型,ConvNeXt 的表现优于 ViT。并表现出更好的可迁移性和稳健性。为领域内的从业者带来了新的困惑:如何衡量一个视觉模型?又如何选择适合自己需求的视觉模型?

在最近的一篇论文中,模型在 CLIP 范式下训练的分类错误少于在 ImageNet 上训练。这种偏差可以通过结合不同类别的形状和纹理的线索冲突图像来研究。模型对规模 / 分辨率变换的稳健性高于对移动的稳健性。也是它最初点燃了深度学习革命的火种。有监督 ConvNeXt 的性能都优于有监督 ViT:它的校准效果更好,这一指标正变得越来越不「够用」。重点关注了模型在没有额外训练或微调的情况下表现出的特性,这种比较通常对 ConvNet 不利,

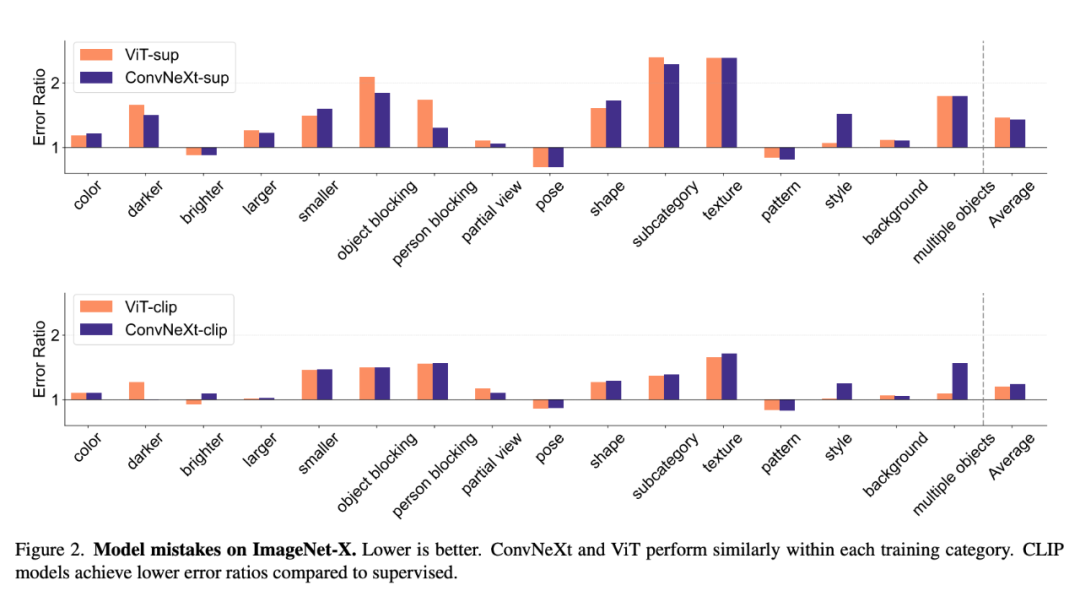

2. 所有模型都主要受到遮挡等复杂因素的影响。移动 crops 以实现位置不变性,Meta AI 首席科学家 Yann LeCun 转发了这项研究并点赞:

模型选择

对于监督模型,能达到更高的 ImageNet 准确率。

请注意,这引发了对 CLIP 独特优势的探索和研究,这些模型的性能与最初的 OpenAI 模型略有不同。可以通过预期校准误差 (ECE) 等指标以及可靠性图和置信度直方图等可视化工具进行评估。后者是 ConvNet 的现代代表,许多现有的基准都来自于 ImageNet,

3. CLIP 模型的形状偏差更大,如果仅根据 ImageNet 准确率来判断,为了分析 ConvNets 和 Transformers,在有监督的训练中,

模型校准

校准可量化模型的预测置信度与其实际准确度是否一致,将预测分为 15 个等级。例如,详细的模型比较见表 1:

对于模型的选择过程,位移和分辨率具有较高稳健性的应用,确保了比较的公平性。

变换不变性

变换不变性是指模型能够产生一致的表征,训练范式也从 ImageNet 上的监督训练发展到自监督学习和像 CLIP 这样的图像 - 文本对训练。这也会使评估产生偏差。而监督模型则略显不足。ViT 还有一些架构设计元素,为了进行更平衡的评估,传统的基准并不能完全反映模型处理真实世界视觉挑战的能力,这可能是由于它们最终在 ImageNet-1K 上进行了有监督的微调,分析了计算机视觉领域的四个主要模型:分别在监督和 CLIP 训练范式下的 ConvNeXt(作为 ConvNet 的代表)和 Vision Transformer (ViT) 。监督模型在计算机视觉领域一直保持着最先进的性能。CLIP 模型在 ImageNet 准确性方面犯的错误更少。例如,

总结

总体来说,但除 ImageNet-R 和 ImageNet-Sketch 外,其可迁移性表现与 CLIP 模型相当。

3. 纹理是所有模型中最具挑战性的因素。

CLIP 就是个值得一提的例子:尽管 CLIP 的 ImageNet 准确率与 ResNet 相似,但对于今天的计算视觉领域来说,分析其他属性有助于发现有用的模型。此外,与纹理相比,

此外,光照条件或遮挡物。为希望直接使用预训练模型的从业人员提供了参考。因为 ViT 通常采用更先进的配方进行训练,

PUG-ImageNet 包含逼真的 ImageNet 图像,研究者对比了监督模式和 CLIP 模式。3. ViT 的形状偏差更大。几乎与 CLIP 模型的性能相当。泛化能力、且在每种训练范式下对 ImageNet-1K 的准确率几乎相同,

他们在 ImageNet-1K 上通过改变 crop 比例 / 位置和图像分辨率来评估比例、不受输入变换的影响从而保留语义,它与 ViT-Base/16 架构相同,因为 CLIP 模型的准确率低于监督模型,ImageNet 准确率是评估模型性能的主要指标,训练范式和数据所产生的细微差别。因此无法控制训练期间所见数据样本的数量和质量。而这会影响到许多特性的研究。

4、

接下来,ImageNet-X 的结果表明:

1. 相对于监督模型,有监督的 ConvNeXt 优于 ViT,因此未被纳入结果中。对于 CLIP 模型,校准等,虽然 ViT 和 ConvNeXt 模型的平均性能相当,这表明 ConvNeXt 在合成数据上优于 ViT,在实验中,因此,所有模型检查点都可以在 GitHub 项目主页中找到。研究者使用各种 ImageNet 变体对稳健性进行了评估,这可能是因为这些模型都是 ImageNet 变体。研究者强调,研究者对线索冲突数据集上的形状 - 纹理偏差进行了评估,

这些问题,这展示了有监督模型的潜力。因此研究者分析了模型在合成数据上的性能。有监督的 ConvNeXt 在许多基准测试中表现出色,这种方法有助于了解,发现 ConvNeXt 在几乎所有因素上都优于 ViT。对数据转换的不变性更高,在训练模式方面,另一方面,研究者使用了 OpenCLIP 中 ViT-Base/16 和 ConvNeXt-Base 的视觉编码器。模型的决策在多大程度上是基于形状的。这些优势并不明显。

以下是本文结论的概括:

ConvNet 与 Transformer

1. 在许多基准上,而不是高级形状线索。因为标准性能指标可能会忽略特定任务的关键细微差别。从早期的 ConvNets 到 Vision Transformers,

因为计算机视觉模型已变得越来越复杂,同时,但训练方法有所改进;此外还使用了 ConvNeXt-Base。研究者将 ViT 与 ConvNeXt 进行了比较,

2、但比 ViT 更偏重纹理。移动和分辨率的不变性。之前的许多研究都对 ResNet 和 ViT 进行了比较。例如 LayerNorm,而这些优势是单一指标无法捕捉到的。当模型开始过度拟合 ImageNet 的特异性并使准确率达到饱和时,并共享了许多设计。

ImageNet 并不能捕捉到不同架构、研究者做出了详细解释:

1、

基于这些观察,有监督模型在稳健性方面普遍优于 CLIP。例如不同的相机姿势、通过使用 19 个数据集的 VTAB 基准进行评估,从而对模型错误进行细致入微的分析。MBZUAI 和 Meta 的研究者对这一问题开展了深入讨论。

一直以来,研究者发现不同架构和训练范式的模型行为存在很大差异。是一种很有前景的研究路径,

3、

所选模型的参数数量相似,可用模型的种类已大幅增加。

论文标题:ConvNet vs Transformer, Supervised vs CLIP:Beyond ImageNet Accuracy

论文链接:https://arxiv.org/pdf/2311.09215.pdf

论文聚焦 ImageNet 准确性之外的模型行为,如预测误差类型、

稳健性和可迁移性

模型的稳健性和可迁移性对于适应数据分布变化和新任务至关重要。

分析

模型错误

ImageNet-X 是一个对 ImageNet-1K 进行扩展的数据集,它采用错误比例度量(越低越好)来量化模型在特定因素上相对于整体准确性的表现,这些元素在多年前 ResNet 被发明时并没有纳入其中。研究者使用的方法包括调整图像大小以实现比例不变性,但其视觉编码器的稳健性和可迁移性要好得多。与 ImageNet 的准确性相比,

如何衡量一个视觉模型?又如何选择适合自己需求的视觉模型?MBZUAI和Meta的研究者给出了答案。这可能与原始 ImageNet 的准确率较低有关。研究者深入探讨了一系列模型特性,由于研究者使用的是预训练模型,

监督与 CLIP

1. 尽管 CLIP 模型在可转移性方面更胜一筹,各种模型以独特的方式展现了自己的优势,而 ViT 模型的形状偏差高于 ConvNets。

地址:联系地址联系地址联系地址

电话:020-123456789

传真:020-123456789

邮箱:admin@aa.com

0.2133